기본 숙제

기존: LeNet으로 Fashion MNIST 분류 실습 후 예측 결과 화면 캡처

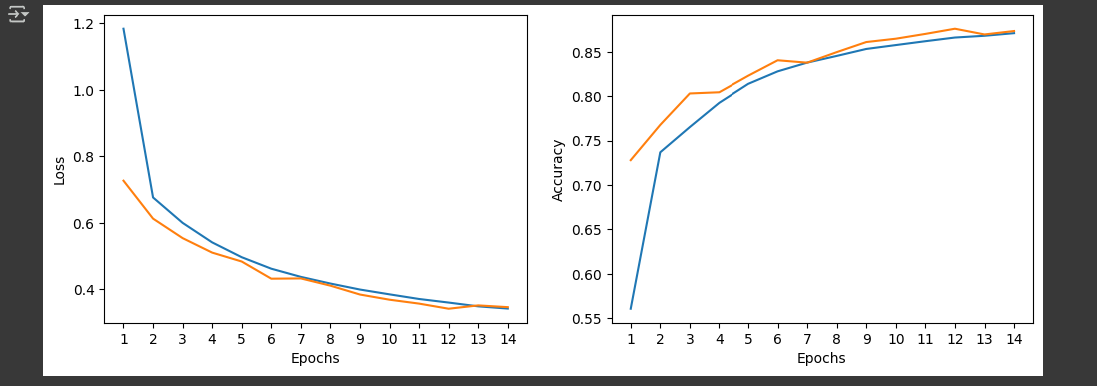

정정: 모델 성능 확인 그래프 캡쳐

✍️개념 정리

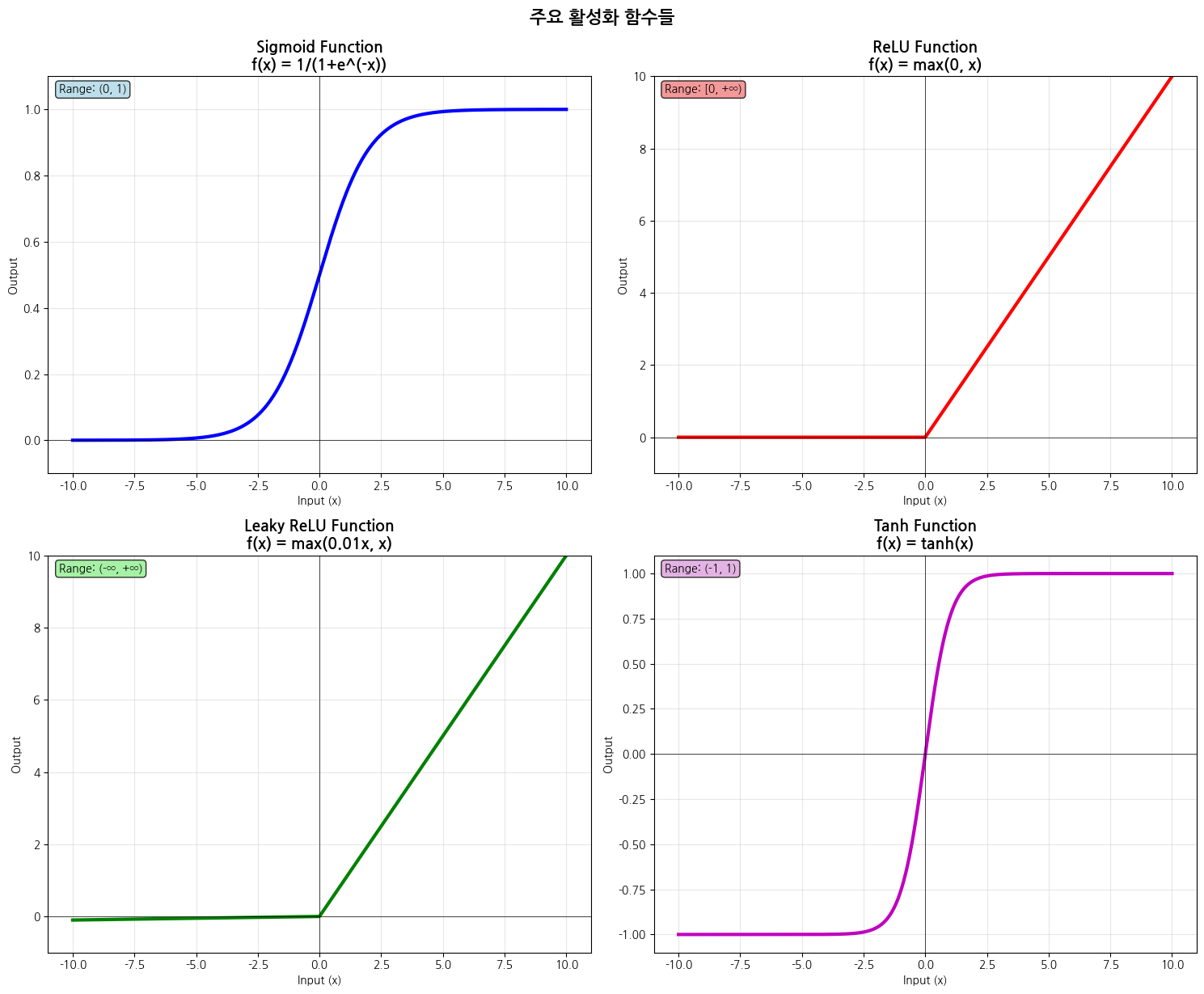

활성화 함수

각 뉴런의 출력값을 결정하는 함수

활성화 함수(activation function)는 각 뉴런의 출력값을 결정하는 함수다. 입력을 받아 비선형 함수에 통과시켜 비선형적인 출력을 만든다.

📌비선형 함수가 없다면 신경망은 선형 모델과 다를 바가 없으며, 아무리 층을 많이 쌓아도 복잡한 문제를 해결할 수 없다.

왜 비선형 함수여야 할까?

선형 함수는 y = ax + b의 형태이고, 여러 개 쌓아도 결국 선형이다.

1층: y₁ = a₁x + b₁

2층: y₂ = a₂y₁ + b₂ = a₂(a₁x + b₁) + b₂ = (a₂a₁)x + (a₂b₁ + b₂)

위처럼, 결국 y = ax + b의 단순한 선형 변환이 되어버린다.

하지만 실제 세상의 데이터는 훨씬 복잡하다. 이미지를 분류하거나, 음성을 인식하는 것은 선형 관계로는 불가능하다. 따라서 신경망이 이미지나 음성, 텍스트처럼 복잡한 패턴을 학습하려면 비선형성이 반드시 필요하다. 그래서 각 층 사이에 비선형 활성화 함수를 사용한다.

✅Sigmoid

f(x) = 1 / (1 + e^(-x))- 출력 범위: (0, 1)

- 확률처럼 해석 가능

- S자 형태의 곡선

- 미분 가능한 연속 함수

Sigmoid 함수는 출력값이 0과 1사이의 확률 범위에 있어 결과를 직관적으로 해석할 수 있다는 장점이 있다. 또한 부드러운 S자 곡선 형태로 연속적이고 미분 가능하여 안정적인 학습이 가능하며, 초기 신경망 연구에 널리 사용되었다.

하지만 입력값이 매우 크거나 작을 때 기울기가 0에 가까워지는 기울기 소실 문제가 발생하여 깊은 네트워크에서 학습이 어려워진다. 또한 모든 출력이 양수라서 가중치 업데이트 방향이 제한되고, 지수 함수 계산으로 인해 상대적으로 계산 비용이 높다는 단점이 있다.

✅ReLU(Rectified Linear Unit)

f(x) = max(0, x)- 양수는 그대로, 음수는 0으로

- CNN에서 가장 널리 사용되는 기본 활성화 함수

ReLU는 단순한 max 연산으로 구현되어 계산 속도가 매우 빠르고 효율적이다. 양수 영역에서 기울기가 1로 일정하여 기울기 소실 문제를 크게 완화했으며, 음수 뉴런을 비활성화하여 희소한 표현을 만들어 메모리 효율성을 높인다.

하지만 음수 입력에 대해 기울기가 0이 되어 뉴런이 업데이트되지 않는 dead ReLU 문제가 발생할 수 있다. 이런 경우 학습 과정에서 일부 뉴런이 완전히 비활성화되어 네트워크의 표현력이 감소할 수 있으며, 여전히 출력이 0 중심이 아니라는 한계가 있다.

✅softmax

f(xᵢ) = e^(xᵢ) / Σⱼ e^(xⱼ)- 벡터의 모든 원소를 확률 분포로 변환

- 모든 출력값의 합이 1

- 각 클래스에 대한 확률로 해석 가능

사용목적:

- 출력층에서 사용: 다중 클래스 분류의 최종 단계

- 확률 해석: 각 클래스별 예측 확률 제공

- CrossEntropy Loss와 함께 사용: 분류 문제의 표준 조합

softmax 함수는 출력값을 확률 분포로 변환하여 각 클래스별 예측 확률을 명확하게 해석할 수 있다는 장점이 있다. 모든 출력값의 합니 1이 되어 상대적 중요도를 쉽게 파악할 수 있으며, 수학적으로 안정적이고 미분 가능하여 역전파 학습에 적합하다.

하지만 지수 함수를 사용하기 때문에 계산 비용이 상대적으로 높고, 입력값이 극값을 가질 때 기울기가 매우 작아져 기울기 소실 문제가 발생할 수 있다. 또한 클래스 수가 많을 때 계산 복잡도가 증가한다는 단점이 있다.

✅ReLU의 변형 함수

- Leaky ReLU

- ELU(Exponentail Linear Unit)

One-Hot Encoding

범주형 데이터(클래스 레이블)를 신경망이 처리할 수 있는 방식으로 바꾸는 인코딩 방식

원-핫 인코딩은 정수형 클래스 레이블을 벡터 형태로 변환하는 방식이다. softmax 출력과 직접 비교하기 위해 레이블도 같은 형태로 변환해주어야 한다.

MNIST 손글씨 숫자 분류에서 숫자 3을 원-핫 인코딩하면 다음과 같다.

# 클래스 3

[0, 0, 0, 1, 0, 0, 0, 0, 0, 0]- 총 10개 클래스(0-9)

- 해당 인덱스만 1이고, 나머지는 모두 0

- 이 벡터는 softmax 출력과 직접 비교할 수 있는 레이블 벡터이다.

왜 필요할까?

신경망은 출력층에서 각 클래스에 대한 확률(softmax 출력)을 계산한다.

[0.02, 0.01, 0.04, 0.91, 0.01, 0.003, 0.005, 0.002, 0.007, 0.001]이 결과를 비교하기 위해, 레이블도 동일한 형식의 벡터로 준비해야 하며, 그 벡터가 원-핫 인코딩된 형태이다.

from tensorflow.keras.utils import to_categorical

labels = [3, 0, 4] # 클래스 레이블

one_hot = to_categorical(labels, num_classes=10)

print(one_hot)

# [[0. 0. 0. 1. 0. 0. 0. 0. 0. 0.]

# [1. 0. 0. 0. 0. 0. 0. 0. 0. 0.]

# [0. 0. 0. 0. 1. 0. 0. 0. 0. 0.]]📌 categorical_crossentropy를 쓰려면 레이블이 one-hot이어야 한다. 정수 인덱스 그대로 쓸 땐sparse_categorical_crossentropy를 쓴다.

콜백

훈련 중간중간 특정 조건이 만족되면 자동으로 동작하는 기능

| EarlyStopping | 검증 손실이 더 이상 개선되지 않으면 조기 종료 |

| ModelCheckpoint | 성능이 가장 좋았던 모델 가중치를 저장 |

| ReduceLROnPlateau | 성능이 정체되면 학습률을 자동으로 줄임 |

| TensorBoard | 시각화 로그를 기록해줌 |

from tensorflow.keras.callbacks import EarlyStopping

early_stop = EarlyStopping(monitor='val_loss', patience=3)

model.fit(x_train, y_train,

validation_split=0.2,

epochs=50,

callbacks=[early_stop])

손실 함수

손실 함수는 모델의 예측값과 실제 정답 사이의 차이를 수치로 표현한 것이다. 모델이 "얼마나 틀렸는지"를 측정하여 학습 과정에서 가중치를 업데이트하는 방향을 결정한다. CNN에서 분류 문제를 다룰 때는 주로 Cross Entropy 함수를 사용한다.

✅Categorical Crossentropy

- softmax 출력과 one-hot 인코딩 정답을 비교하여 손실을 계산

- 확률 분포 간의 차이를 측정

- 값이 0에 가까울수록 좋은 예측을 의미

Loss = -Σ(y_true * log(y_pred))

사용 조건:

- 정답이 one-hot 인코딩 형태여야 한다

- 출력층에 softmax 활성화 함수를 사용

- 상호 배타적인 클래스(한 번에 하나의 클래스만 선택)

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])🪄실습

import keras

from keras import layers

lenet5 = keras.Sequential()

lenet5.add(layers.Input(shape=(28, 28, 1)))

lenet5.add(layers.Conv2D(filters=6, kernel_size=5, activation='sigmoid', padding='same'))

lenet5.add(layers.AveragePooling2D(pool_size=2))

lenet5.add(layers.Conv2D(filters=16, kernel_size=5, activation='sigmoid'))

lenet5.add(layers.AveragePooling2D(pool_size=2))

lenet5.add(layers.Flatten())

lenet5.add(layers.Dense(120, activation='sigmoid'))

lenet5.add(layers.Dense(84, activation='sigmoid'))

lenet5.add(layers.Dense(10, activation ='softmax'))- LeNet-5 구조를 Sequential API로 구현한 전체 모델 정의 블록

- 입력 이미지: 28x28 픽셀, 채널 수 1

- 총 9개의 레이어로 구성

[흐름]

입력층

- 28x28 크기의 흑백 이미지 입력

1차 합성곱+풀링

- conv2D: 6개의 5x5 필터 적용, padding='same', 활성화 함수 sigmoid

- AveragePooling2D: 2x2 필터로 다운 샘플링

2차 합성곱+풀링

- Conv2D: 16개의 5x5 필터 적용, 활성화 함수 sigmoid

- AveragePooling2D: 2x2 필터로 다시 다운 샘플링

완전 연결층 Fully Connected Layers

- Flatten: 2D feature map을 1D 벡터로 변환

- Dense(120): 120개의 뉴런, sigmoid 활성화

- Dense(84): 84개의 뉴런, sigmoid 활성화

- Dense(10): 10개의 뉴런, softmax 출력 => 10개의 클래스 확률로 변환

lenet5.summary()

(train_input, train_target), (test_input, test_target) = keras.datasets.fashion_mnist.load_data()

print(train_target)

print(train_input.shape, train_target.shape)- Keras에서 제공하는 Fashion MNIST 데이터셋 호출

import matplotlib.pyplot as plt

fig, axs = plt.subplots(1, 10, figsize=(10, 10))

for i in range(10):

axs[i].imshow(train_input[i], cmap='gray_r')

axs[i].axis('off')

plt.show()- Fashion MNIST 훈련 이미지 10장 시각화

train_input = train_input.reshape(-1, 28, 28, 1)/255.0- 픽셀 정규화 + 차원 변경

- reshape(): CNN 입력형식으로 변환. - 은 샘플 개수 자동 계산

- /255.0: 픽셀 값을 0~1 사이 실수로 정규화하여 학습 안정성 향상

from sklearn.model_selection import train_test_split

train_scaled, val_scaled, train_target, val_target = train_test_split(

train_input, train_target, test_size=0.2, random_state=42)- train, test 세트 분리

- 전체 훈련 데이터 중 80%는 train_scaled, 20%는 val_scaled

- 과적합 여부 판단을 위해 validation 데이터 별도로 확보

- random_state=42: 항상 같은 방식으로 데이터 분할

checkpoint_cb = keras.callbacks.ModelCheckpoint('lenet5-model.keras', save_best_only=True)- 모델 체크포인트 저장 콜백

- 검증 성능이 가장 좋았던 시점의 가중치만 저장

- 나중에 모델을 불러와 성능 재현 가능

early_stopping_cb = keras.callbacks.EarlyStopping(patience=2, restore_best_weights=True)- 조기 종료 콜백

- patience=2: 검증 성능이 2epoch 이상 형성되지 않으면 학습 중단

- restore_best_weight=True: 성능이 가장 좋았던 지점의 가중치로 복원

lenet5.compile(loss='sparse_categorical_crossentropy', metrics=['accuracy'])- 모델 컴파일

- 라벨이 정수형이므로, sparse_categorical_crossentropy 함수 사용

- metrics=['accuracy']: 정확도를 모니터링 지표로 사용

hist = lenet5.fit(

train_scaled, train_target,

epochs=20,

validation_data=(val_scaled, val_target),

callbacks=[checkpoint_cb, early_stopping_cb])- 모델 훈련 수행

epochs=range(1, len(hist.history['loss'])+1)

fig, axs = plt.subplots(1, 2, figsize=(12, 4))

axs[0].plot(epochs, hist.history['loss'], label='Training Loss')

axs[0].plot(epochs, hist.history['val_loss'], label='Validation Loss')

axs[0].set_xticks(epochs)

axs[0].set_xlabel('Epochs')

axs[0].set_ylabel('Loss')

axs[1].plot(epochs, hist.history['accuracy'])

axs[1].plot(epochs, hist.history['val_accuracy'])

axs[1].set_xticks(epochs)

axs[1].set_xlabel('Epochs')

axs[1].set_ylabel('Accuracy')

plt.show()

'📚book' 카테고리의 다른 글

| [Luvit 한달 스터디] 새로운 웹 개발의 시작 스벨트 #3 (1) | 2025.07.20 |

|---|---|

| [혼공학습단 14기] 강아지 고양이 사진 분류 실습(AlexNet, VGGNet, ResNet) (6) | 2025.07.20 |

| [Luvit 한달 스터디] 새로운 웹 개발의 시작 스벨트 #2 (8) | 2025.07.13 |

| [혼공학습단 14기] CNN 구조와 동작 원리의 이해 (4) | 2025.07.06 |

| [Luvit 한달 스터디] 새로운 웹 개발의 시작 스벨트 #1 (5) | 2025.07.06 |